|

Édition du: 27/01/2025 |

|

INDEX |

LOGIQUE et IA |

|||

![]()

|

RÉSEAUX DE NEURONES ARTIFICIELS (RNA) Réseau neuronal Neuronique Neuromimétique Connexionisme Neural network Deep learning ou apprentissage profond (ou automatique) AuotoML Système qui imite les neurones vivants. À force

d'apprentissage, le système s'imprègne des conclusions à donner face à une

situation nouvelle. Après avoir connu une période de doute (années

1990), les réseaux de neurones sont de nouveaux très utilisés. Voir un point

rapide sur leur fonctionnement et l'état de l'art en 2016 >>> Le terme

"deep learning or machine learning – apprentissage profond" date de

1959. Il est dû à Arthur Samuel, un informaticien d'IBM. Il s'applique aux

ordinateurs capables d'apprendre sans être directement programmés.

|

|||

|

|

Sommaire de cette page

>>> Approche >>>

Domaine et propriétés >>> Réseaux à apprentissage >>> Réseaux neuronaux >>> Circuit et loi de Hebb |

>>>

Historique >>> Le point en début

2015 >>> Le point en début

2016 >>> Domaine de la

neuronique >>> Réseaux

collaboratifs >>> Automated machine

learning |

Débutants Glossaire |

Lire au

préalable: Traitement automatique de l'information

Voir Dilemme de Sita

– Amusement, sérieux.

Voir Pensées & humour

|

|

Voir Taille de la gravure des

microprocesseurs

![]()

|

Les réseaux de neurones

Applications

Définition

|

|

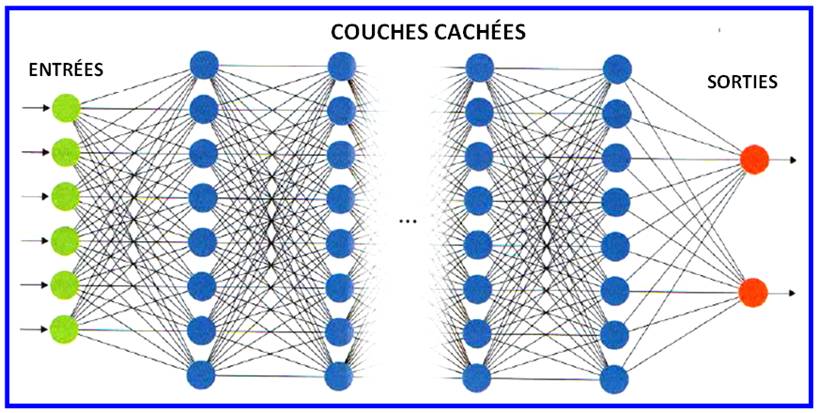

D'après Claude TOUZET - Auteur de cours sur le sujet

Structure

d'un réseau de neurones

|

Les réseaux de neurones reposent sur des

associations de valeurs, de simples chiffres, à l'aide de fonctions

mathématiques reliant les sorties aux entrées. Chaque point d'une image, ou

d'un texte, se voit attribuer des valeurs d'entrée. Toute la magie repose sur

l'entrainement des fonctions à mémoriser les situations rencontrées (entrées

et sorties connues) pour réussir à effectuer une tâche nouvelle de manière

cohérente pour nous. Source

image: Découverte n°446 – Juillet-septembre 2024 |

|

Domaines

Propriétés

|

|||||||||||||||||||||

|

|

||

|

Exemple 1 – Aller au bureau, au

supermarché …

----

----

----

---- Etc. Exemple 2 – Reconnaître le chant du

rossignol

Apprentissage

|

||

|

|

|

|

Avec les réseaux neuronaux

Réseaux de neurones – Caractérisation

|

|

|

|

||

|

PRINCIPE DE FONCTIONNEMENT du

réseau de neurones

SORTIES =

f (ENTRÉES et, des SORTIES précédentes)

SORTIES =

f(ENTRÉES pondérées et des SORTIES précédentes) Les pondérations sont

données par le système au fur et à mesure

de l'apprentissage. Principe des réseaux multicouches

LOI de HEBB

|

||

|

HISTORIQUE |

|

||

|

1890 |

W.

James |

|

|

|

1942 |

Norbert

Wiener |

|

|

|

1943 |

McCulloch

et Pitts |

|

|

|

1949 |

Hebb |

|

|

|

1957 |

Frank

Rosenblatt |

|

|

|

Algorithme inventé en 1957 par Frank

Rosenblatt, au sein du Cornell Aeronautical Laboratory. Études inspirées par

les théories cognitives de Friedrich Hayek et Donald Hebb. La première implémentation du perceptron fut effectuée sous la forme

d’un logiciel pour l’IBM 704, mais il a ensuite été implémenté dans une

machine créée spécialement pour l’occasion baptisée Mark 1. Conçue pour la reconnaissance d’image, elle

regroupait 400 cellules photoélectriques connectées à des neurones. Les poids

synaptiques étaient encodés dans des potentiomètres, et les changements de

poids pendant l’apprentissage étaient effectués par des moteurs électriques.

Cette machine est l’un des tout premiers réseaux de neurones artificiels. Le perceptron ne comportait qu'une

seule couche. Avec les progrès de la technologie, les multicouches permirent

de traiter les problèmes complexes. |

|

1960 |

B.

Widrow |

|

|

1969 |

Minsky

et Papert |

|

|

1982 |

John

Hopfield |

|

|

1983 |

Boltzmann* |

|

|

1985 |

|

|

|

1986 |

Werbos

puis Rumelhart, Hinton

et Williams |

|

* Nom

et Prénom à vérifier :

Ce

n'est pas le célèbre Boltzmann de la théorie cinétique des gaz basée sur

l'hypothèse atomiste, avant-gardisme, suicidé en 1906

Voir Historique

complet

|

|

|

|

À l’image du cerveau humain, plusieurs couches de neurones artificiels, reliées

entre elles par des synapses ayant un poids plus ou moins important, sont

entraînées par essai/erreur à réaliser une certaine tâche de prédiction. À la

fin de l’apprentissage, les poids

synaptiques sont réglés de manière optimale pour réussir la tâche en

question. La force de ces méthodes est d’être capable d’apprendre par

analogie sans que le modélisateur ait besoin d’émettre de règles a priori sur la relation entre données

d’entrée et de sortie. La reconnaissance de l’écriture manuscrite en est un

"cas d’école" classique : alors qu’il est très difficile d’émettre

de règles précises sur la forme de telle ou telle lettre dans une image traduite en

tableau de pixels, les

réseaux de neurones sont quasi-infaillibles sur ce problème – Yseulys Costes

|

|

D'après l'Atelier: Huge

data par Yseulys Costes

La puce TrueNorth d'IBM – 2014

|

Puce neurosynaptique TrueNorth d'IBM:

grande comme un timbre-poste

IBM

a assemblé 16 puces atteignant 16 millions de neurones et 4 milliards de

synapses. |

|

|

||

|

Dans les années 1990, les réseaux de

neurones furent boudés en raison de l'existence de nombreux blocages sur des

points critiques, les minimums locaux. Des travaux récents ont permis d'identifier

et de contourner cette difficulté. Fonctionnement Les neurones artificiels sont des

blocs de code informatique qui

reproduisent de manière simplifiée l'action des neurones biologiques. Chacun

est doté de plusieurs entrées et d'une sortie. Les entrées reçoivent des

informations provenant des sorties des neurones précédents (effet synapse). La connexion entre deux neurones est

caractérisée par un poids synaptique, un

nombre qui qualifie la pertinence de la liaison, une sorte d'effet de mémoire. Ce sont ces valeurs qui vont

s'affiner avec l'apprentissage. Plus cette

liaison sera impliquée dans l'indication de la bonne réponse et plus le poids

va augmenter. Après un long apprentissage, les

poids se stabilisent et le réseau à atteint sa configuration opérationnelle;

prêt à se confronter à des situations nouvelles. |

Auteurs: Yoshua Bengio (né en 1964), directeur de

l'Institut des algorithmes de Montréal et Yann

LeCun (photo), directeur du laboratoire d'intelligence artificielle de Facebook et leurs

équipes.

Analogie Imaginez

que vous appreniez à faire du ski dans une montagne comportant de nombreux

vallons. Vous apprenez bien et, le jour arrive où vous êtes lâché tout seul.

Tout se passe bien, vous descendez. Puis, vous êtes bloqué. C'est

effectivement un point bas, mais ce n'est pas la station d'arrivée. Vous êtes

dans un minimum local et non dans le minimum global recherché. Il

vous faudra apprendre à chercher la sortie de cette cuvette … |

|

|

Le blocage aux points critiques Dans certains cas, les poids

atteignent une limite qui correspond à un minimum local et non global; comme

si l'algorithme s'était engagé dans une impasse. Les performances du réseau

sont alors bien médiocres et ce phénomène explique le désamour des années

1990. Les auteurs expliquent avoir trouvé

la parade. Ils se focalisent sur les points d'impasse, les points critiques.

Ce sont des points en "selle

de cheval" qui finalement possèdent une sorte. Ils ont également

constaté que ces points critiques sont de moins en moins nombreux dès que la

quantité de neurones grandit considérablement. Ce que permet la technologie

actuelle avec des centaines de millions de

synapses. |

||

D'après C'est

la fin d'une croyance sur les réseaux de neurones Yoshua Bengio interviewé

par Gauthier Cariou

– La Recherche de janvier 2016 – pages 64 et 65

![]()

Le domaine de la neuronique et de

l'intelligence artificielle

|

Le

NIPS (Neural Information Processing Systems) est une conférence scientifique

en intelligence artificielle et en neurosciences computationnelles qui se

tient chaque année à Vancouver, Canada. Sujets d'études:

reconnaissance

de la parole, reconnaissance

d'objets; reconnaissance

de visages; interprétation

des images du cerveau.

Voir NIPS 2014 |

Pour obtenir

les textes présentés lors de ces conférences (anglais) >>>

Mise à jour

de février 2015

Réseaux collaboratifs: systèmes

multi-agents

|

Pour

inventer une IA plus fine et plus frugale, les approches bio-inspirées reviennent en grâce. Les

systèmes multi-agents sont inspirés du

monde des insectes, capables, avec très peu d’intelligence, de réaliser des

choses complexes. Aux États-Unis, l’agence de R & D de l’armée

américaine, la Darpa, a lancé un appel à projets pour une IA fondée sur le

cerveau d’un insecte. Au MIT, des chercheurs ont pris le fonctionnement des

cellules du corps humain comme modèle d’organisation pour créer un essaim de robots collaboratifs. C’est dans cette mouvance

que s’inscrit la start-up AnotherBrain, fondée début 2017 par

Bruno Maisonnier, connu pour ses robots Nao et Pepper créés par sa

première société, Aldebaran. |

Une

nouvelle IA, trouver la clé du cerveau – l 'Usine Nouvelle – Marion Garreau –

17/07/2019

Automated machine learning (AutoML): un

assistant la création d'IA

|

Les défis de l'IA sont de

plus en plus complexes et affaires de spécialistes. Comment mettre les outils

de l'IA à la disposition du plus grand nombre ? L'autoML est un procédé qui

facilité l'accès à l'IA par réseaux de neurones, notamment pour l'automatisation de la création de

modèles d'apprentissage. Ils simplifient la phase de préparation des données

nécessaires à l'apprentissage et

également toutes les phases suivantes. Les sociétés d'informatiques

proposent des solutions comme: DataRobot, Google AutoML, H2O.ai, Azure ML de

Microsoft, Sagemaker Autopilot d'AWS ... C'est aussi le cas des studios de

data science comme le français Dataiku, l'allemand Knime ou l'américain

Rapidminer. |

Source:

Le

machine learning automatisé va-t-il remplacer le data scientist ? – Antoine

Crochet-Damais – JDN – 28/08/2020

![]()

|

Suite |

|

|

Voir |

|

|

Histoire |

|

|

Site

|

|

|

Cette

page |

![]()